20 полезных графиков по оценке SEO-ссылок

22 года назад основатели Google изобрели PageRank, и навсегда изменили веб. Несколько вещей, которые пришли вместе PageRank, резко отличалось от прежних алгоритмов ранжирования и актуальны и сегодня:

- Ссылки в интернете считаются голосами. Изначально все голоса равны.

- Страницы, которые получают больше голосов, становятся более важными (и ранжируются выше.)

- Более важные страницы «отдают» более важные голоса.

Но Google не остановилась на этом: они обновили якорный текст, тематическое моделирование, контент-анализ, сигналы доверия, взаимодействие с пользователями и многое другое, чтобы обеспечить лучшие результаты.

Ссылки больше не равны. Ни в коем случае. В этом посте мы расскажем вам о 20 принципах оценки ссылок, которые были соблюдены и протестированы SEO-специалистами. В некоторых случаях они были подтверждены Google, в то время как другие были запатентованы компанией-источником Moz. Обратите внимание, что это не жесткие правила, а принципы, которые взаимодействуют друг с другом. Всплеск свежих ссылок часто может перевешивать мощные ссылки, спам-ссылки могут притупить эффект свежих ссылок и т. д. Также учитывайте тот факт, что эта информация актуальная для продвижения в Google, с Яндекс система может работать по-другому.

Мы настоятельно рекомендуем вам проверить это на своем бизнесе.

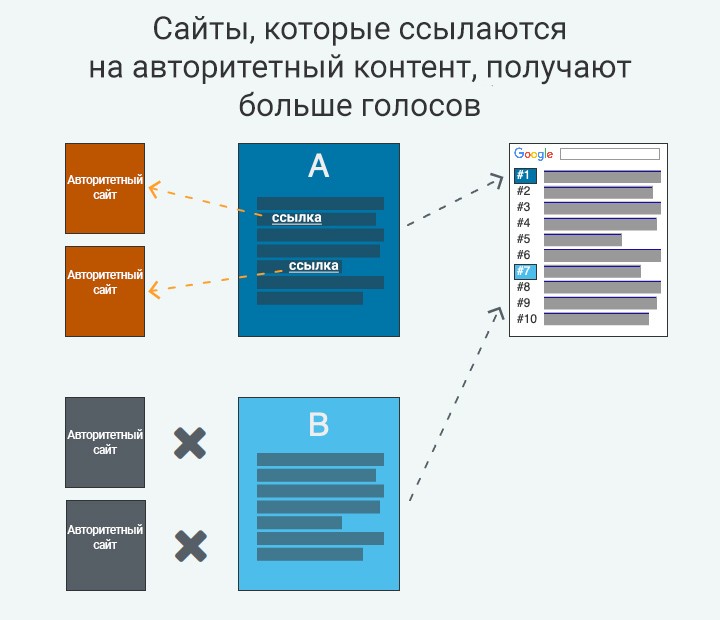

1. Ссылки с популярных страниц дают более мощные голоса

Начнем с основополагающего принципа. Эта концепция легла в основу оригинального патента Google PageRank и быстро помогла сделать его самой популярной поисковой системой в мире.

Чем больше голосов (ссылок) страница указала, тем больше PageRank (и других возможных сигналов на основе ссылок) накапливает сайт. Чем больше голосов он накапливает, тем больше сайт может передать на другие страницы через исходящие ссылки.

В основном, популярные страницы — это те, которые сами набрали много голосов. Оценка ссылки с популярной страницы обычно может быть более эффективной, чем получение ссылки со страницы с меньшим количеством голосов ссылок.

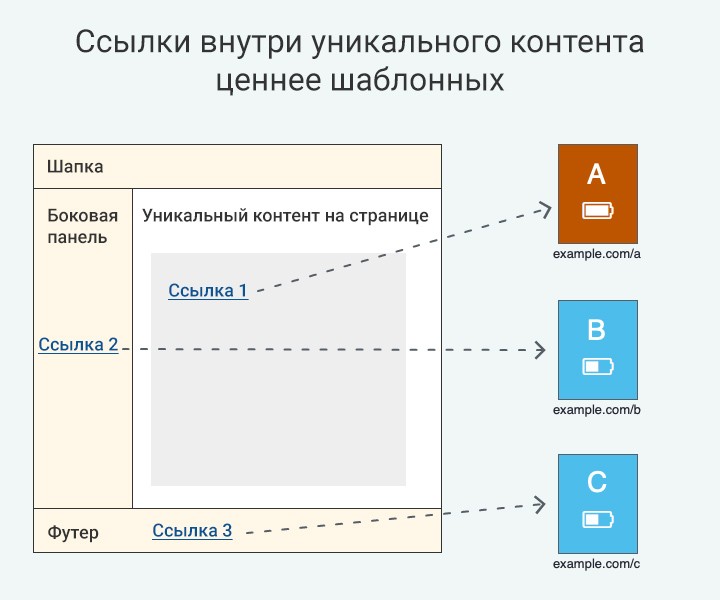

2. Ссылки внутри уникального основного контента ценнее шаблонных ссылок

Если проще — те ссылки, которые вставляются, например, в текст на странице блога на сайте, гораздо ценнее ссылок, расположенных в хедере, футере и других частях сайта, которые размещены там согласно шаблону.

Google разграничивает уникальный контент и шаблонные элементы кода, поэтому это важный сегмент для сайтов, которые работают на популярных CMS. Именно по этой причине важно сосредоточиться на основном содержании страницы.

Аналогичным образом, SEO-эксперименты показали, что ссылки, скрытые в расширяемых вкладках (CSS или JavaScript), могут иметь меньший вес, чем полностью видимые ссылки, хотя Google говорит, что они полностью индексируют эти ссылки.

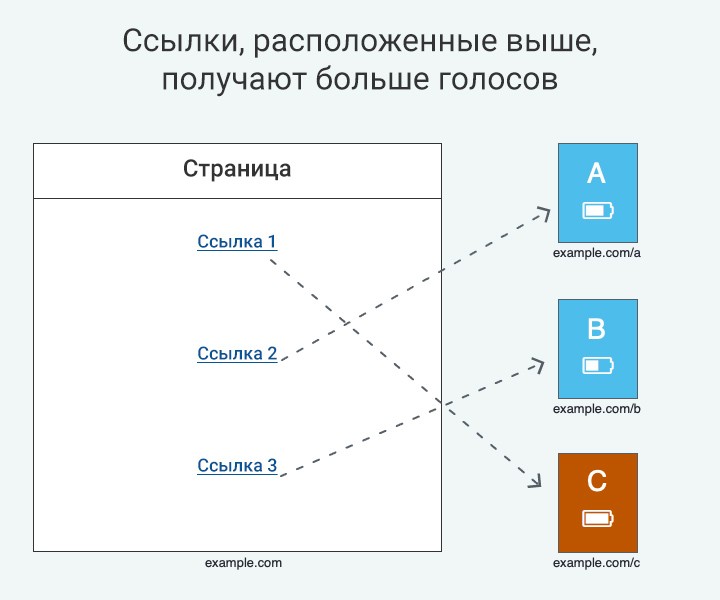

3. Ссылки, расположенные выше в основном контенте, более ценные

Если бы у вас был выбор между 2 ссылками, что бы вы выбрали?

- Одна занимает видное место в первом абзаце страницы

- Другая помещена ниже под несколькими абзацами

Конечно, вы бы выбрали первую, и Google захочет сделать то же самое.

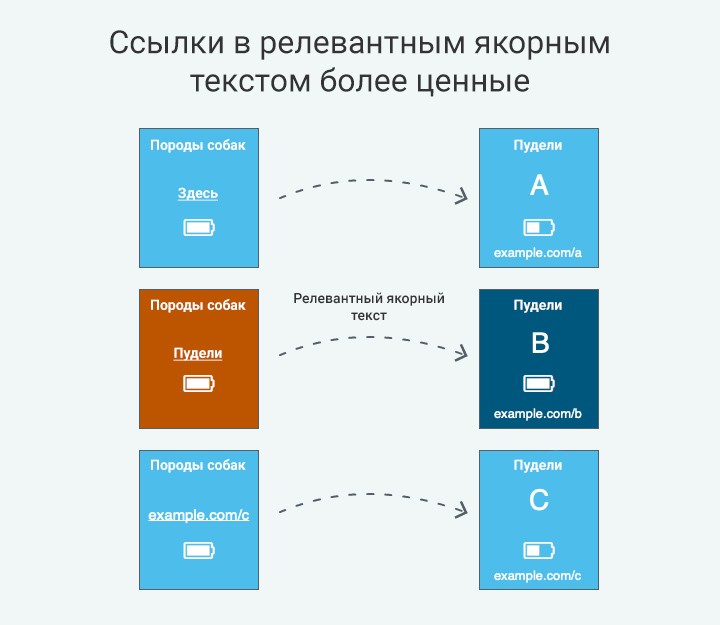

4. Ссылки с релевантным якорным текстом имеют больше значения

Многочисленные эксперименты на протяжении многих лет неоднократно подтверждали способность релевантного якорного текста повышать рейтинг страницы по сравнению с нерелевантным якорным текстом.

Вы не должны спамить свои страницы обилием точных якорей. Страницы должны иметь естественное сочетание соответствующих якорей для исходящих ссылок.

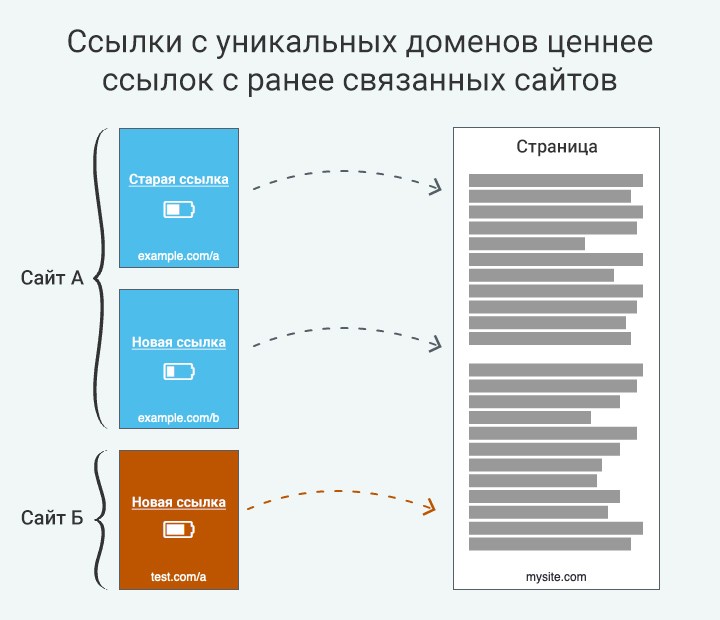

5. Ссылки с уникальных доменов ценнее ссылок с ранее связанных сайтов

Опыт показывает, что гораздо лучше иметь 50 ссылок из 50 различных доменов, чем иметь 500 ссылок с сайта, который уже ссылается на вас.

Это имеет смысл, поскольку алгоритмы Google предназначены для измерения популярности во всей сети, а не просто популярности с одного сайта.

Принцип не всегда универсально верен. Когда стоит выбор: очередная ссылка с хорошего и качественного сайта или ссылка с неизвестного домена, лучше выбрать первое.

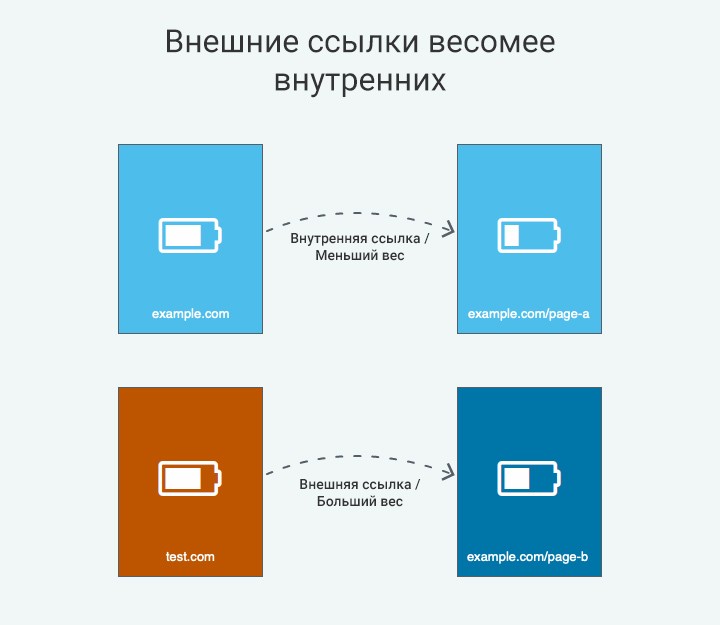

6. Внешние ссылки весомее внутренних

Если мы расширим понятие из пункта 3, то из этого следует, что ссылки с внешних сайтов должны цениться больше, чем внутренние ссылки с вашего собственного сайта.

Это не значит, что внутренние ссылки не учитываются. Напротив, внутренние ссылки и хорошая архитектура сайта могут оказать огромное влияние на рейтинг в поисковой системе. Тем не менее, создание внешних ссылок часто является самым быстрым способом повышения рейтинга и увеличения трафика.

7. Ссылки с авторитетных доменов с высоким TrustRank имеют большее значение

Совсем недавно Google обновил свой оригинальный патент PageRank с разделом, который включает в себя концепцию доверия. То есть сайты, которые получают больше отзывов живых пользователей дают больше «веса», чем внешние ссылки с сайтов, которые пока не заслужили доверие поисковой системы.

8. Ссылки с релевантных тематических сайтов — более ценные

Вы управляете молочной фермой. При прочих равных условиях, вы бы предпочли иметь ссылку от:

- Национальной Ассоциации Молочников

- Ассоциации автомобильных механиков

Вы выберете первый пункт, потому что это более актуально. Хотя существует несколько механизмов, Google может действовать таким же образом в отношении актуальных ссылок, включая тематический PageRank, индексирование на основе фраз и локальное взаимодействие.

Эта схема также помогает исключить спам-ссылки с нерелевантных страниц.

9. Ссылки с новых страниц имеют больший вес, по сравнению со ссылками со старых страниц

Основная концепция заключается в том, что страницы со ссылками с более свежих страниц — например, новые страницы и те, которые регулярно обновляются — скорее всего, более актуальны, чем страницы со ссылками с большей частью устаревших страниц или страниц, которые не обновлялись некоторое время.

Важно отметить, что «старый» — это не то же самое, что неакутальный. Неактуальная страница:

- Не обновляется, часто с устаревшим контентом

- Зарабатывает меньше новых ссылок с течением времени

- Показывает снижение вовлеченности пользователей

Если страница не соответствует этим характеристикам, ее можно считать свежей — независимо от ее фактического возраста.

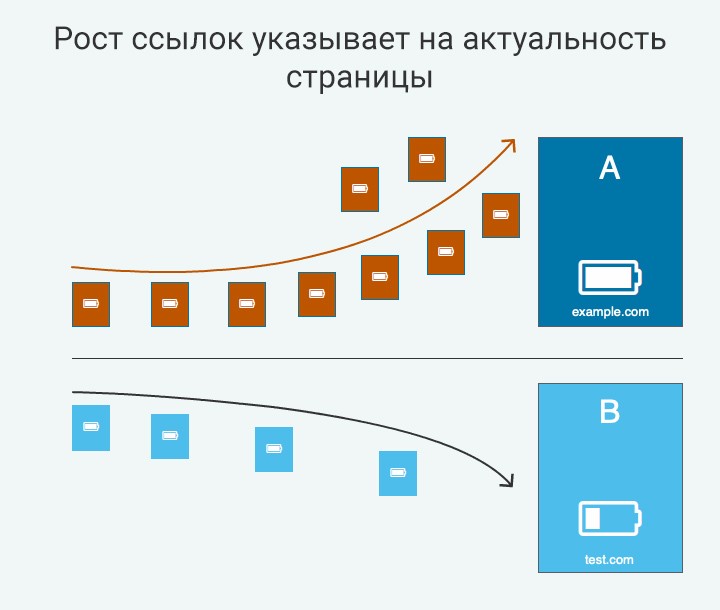

10. Рост ссылок указывает на актуальность страницы

Если Google видит всплеск новых ссылок на страницу, это может указывать на сигнал релевантности.

По той же логике снижение общего темпа роста ссылок будет указывать на то, что страница устарела и, вероятно, будет снижаться в результатах поиска.

Все эти концепции свежести и многое другое охватываются информационным поиском Google на основе Information retrieval based on historical data.

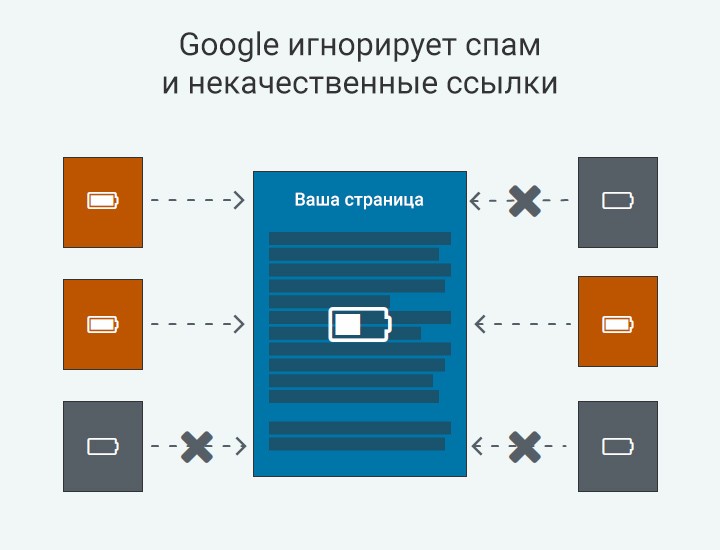

11. Google обесценивает спам и некачественные ссылки

Хотя в интернете есть триллионы ссылок, правда в том, что Google, вероятно, игнорирует большую их часть.

Цель поисковой системы — сосредоточиться на редакционных ссылках, например уникальных ссылках, которые вы не контролируете, свободно размещенных другими. Начиная с Penguin 4.0, Google игнорировал ссылки, которые не соответствуют этим стандартам. Например, созданные с помощью схемы обмена ссылками.

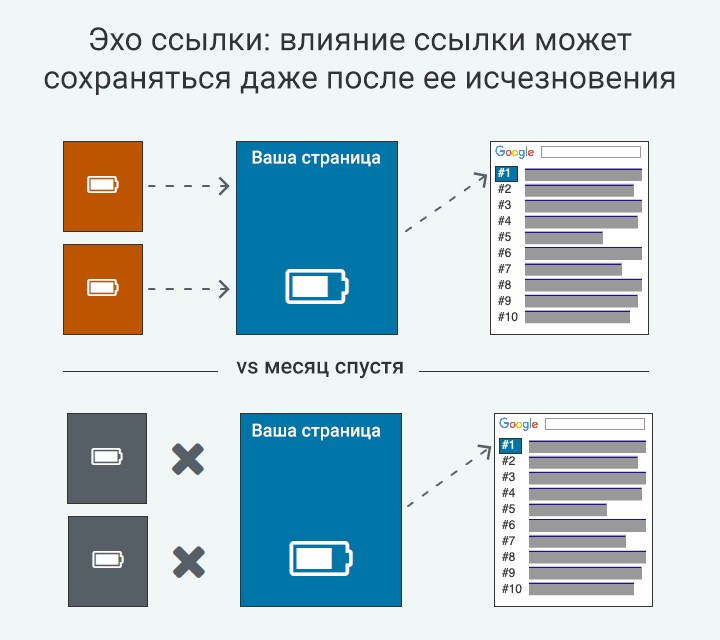

12. Эхо ссылки: влияние ссылки может сохраняться даже после ее исчезновения

Эффект реверберации ссылок или «призрачные ссылки» действительно имеет место быть: через несколько месяцев после того, как ссылки удалили со страницы, Google может зайти и проиндексировать эти страницы все равно.

Почему так происходит? Google смотрит на другие факторы ранжирования после того, как страница поднялась в рейтинге (например, взаимодействие с пользователем), Google присваивает постоянство или деградацию ссылочной массе, и отдельные ссылки перестают иметь значение.

13. Ссылки на авторитетные ресурсы получают больше голосов

Хотя Google утверждает, что привязка к качественным сайтам не является явным фактором ранжирования, ранее были заявления о том, что это может повлиять на производительность поиска.

Точно так же, как Google меньше доверяет сайтам, когда они ссылаются на спам-сайты, части системы поощряют ссылки на хорошие сайты.

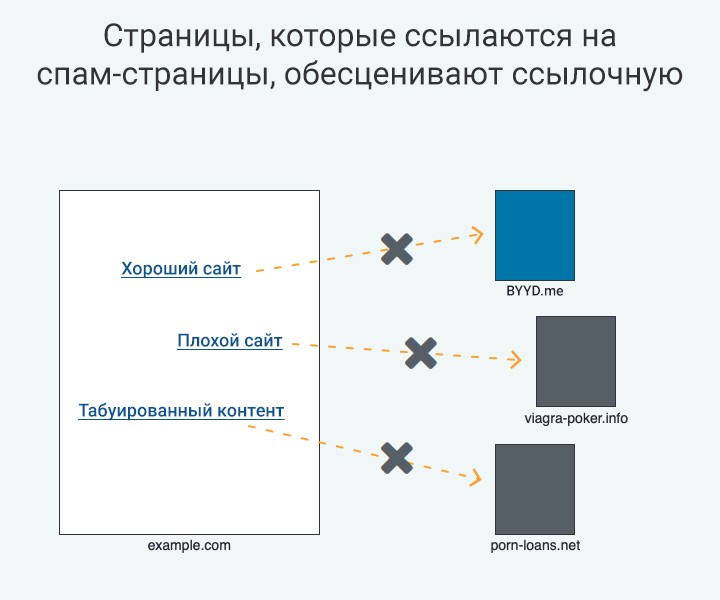

14. Страницы, которые ссылаются на спам, обесценивают ссылочную массу

Если взять во внимание утверждение из первого пункта, то станет понятно, что Google меньше доверяет сайтам, когда они ссылаются на спам.

Эта концепция может быть расширена дальше, так как есть достаточно доказательств того, что Google понижает сайты, которые, по его мнению, размещают платные ссылки.

Еще это работает следующим образом: если 2 из 3 ссылок на странице ссылаются на спам, то 3-я не будет иметь вес.

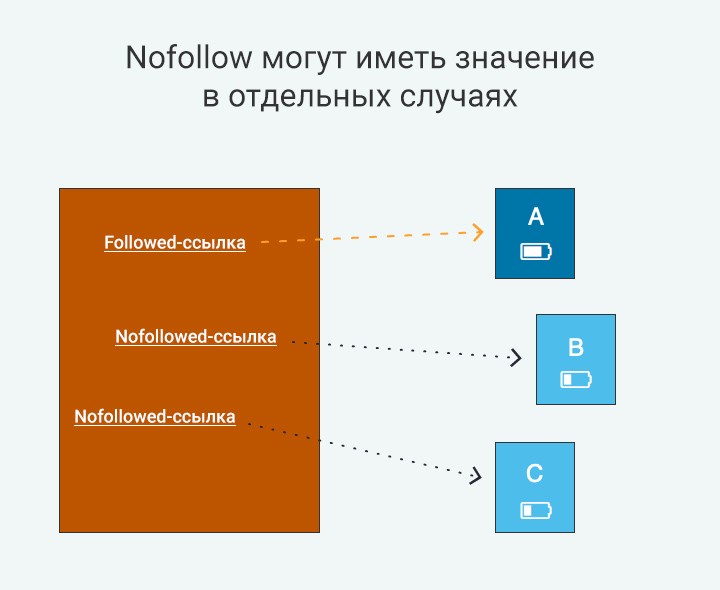

15. Nofollow могут иметь значение в отдельных случаях

Google изобрел ссылку nofollow специально, потому что многие веб-мастера обнаружили, что трудно предотвратить спам, исходящие ссылки на своих сайтах — особенно те, которые генерируются спамом в комментариях.

Тем не менее, многочисленные SEO-эксперименты свидетельствуют о том, что ссылки nofollow могут иметь некоторую ценность, и веб-мастерам было бы разумно максимизировать их ценность.

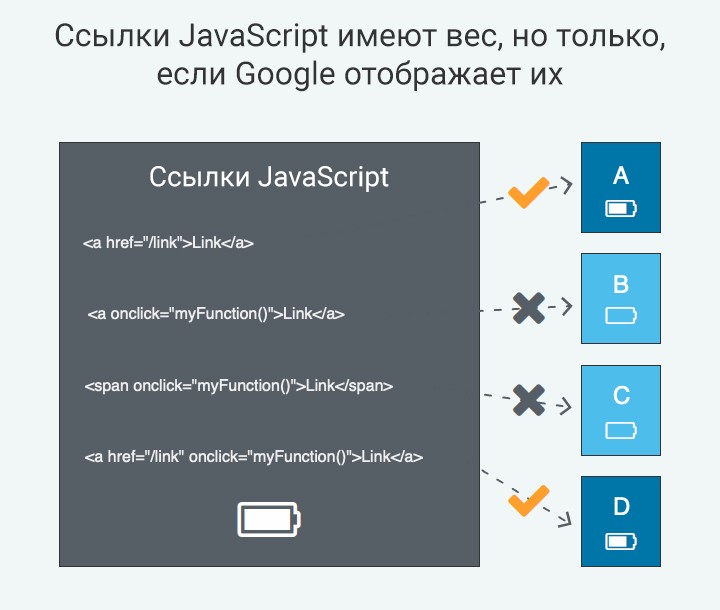

16. Ссылки JavaScript имеют вес, но только, если Google отображает их

В старые времена SEO было обычной практикой скрывать ссылки с помощью JavaScript, зная, что Google не может их сканировать.

Сегодня Google значительно улучшил обход и рендеринг JavaScript, так что большинство ссылок JavaScript сегодня будут учитываться.

Тем не менее, Google по-прежнему не может сканировать и индексировать каждую ссылку JavaScript. Во-первых, им нужно дополнительное время и усилия для рендеринга JavaScript, и не каждый сайт предоставляет совместимый код. Во-вторых, Google рассматривает только полные ссылки с тегом привязки и атрибутом href.

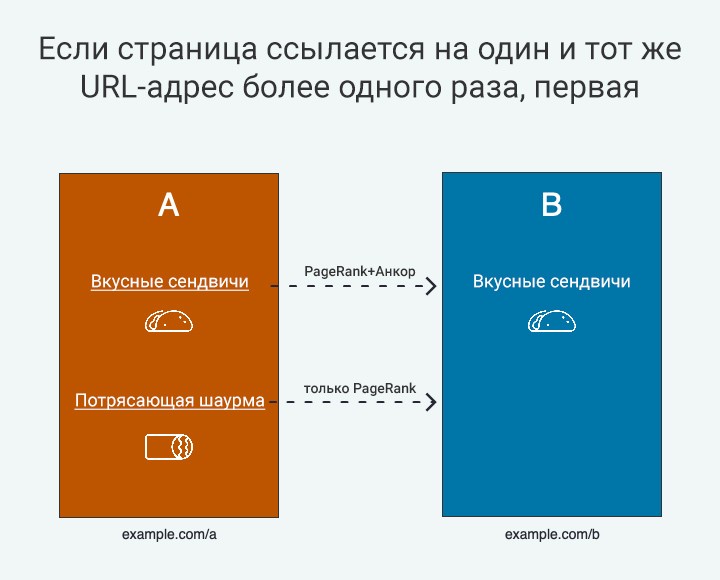

17. Если страница ссылается на один и тот же URL-адрес более одного раза, первая ссылка имеет приоритет

… Или, более конкретно, учитывается только первый анкор.

Если Google просматривает страницу с двумя или более ссылками, указывающими на один и тот же URL-адрес, PageRank обычно проходит через оба, но будет использоваться только первый анкор для целей ранжирования.

Благодаря тестированию обнаружено несколько умных способов обойти правило приоритета первой ссылки, но новые исследования не публиковались в течение нескольких лет.

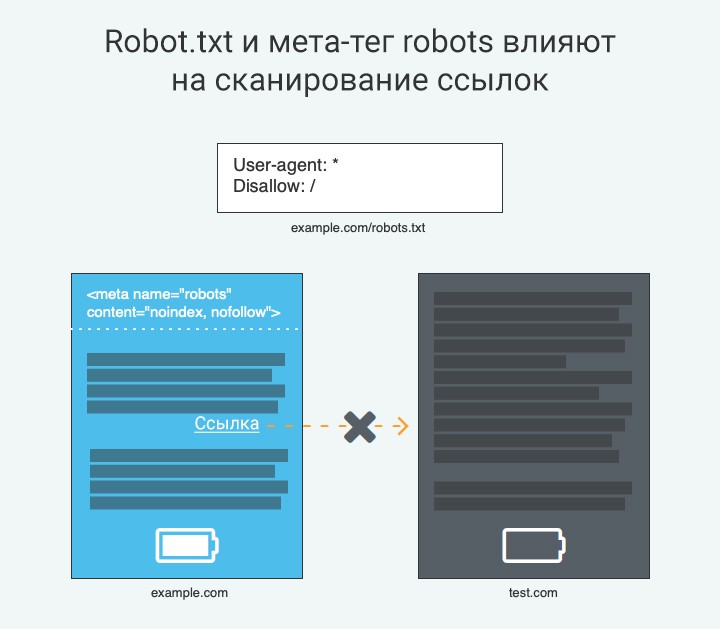

18. Robot.txt и мета-тег robots влияют на сканирование ссылок

Для того чтобы Google взвешивал ссылку в своем алгоритме ранжирования, он должен иметь возможность сканировать и следовать за ней. Неудивительно, что существует ряд директив на уровне сайта и страницы, которые могут мешать Google. К ним относятся::

- URL-адрес блокируется от обхода Robot.txt

- Мета-тег robots HTTP-заголовок X-Robots-Tag используют директиву nofollow

- Страница настроена на noindex, follow, но Google в конечном итоге перестает сканировать

Часто Google будет включать URL в свои результаты поиска, если другие страницы ссылаются на него, даже если эта страница заблокирована Robot.txt. Но поскольку Google не может сканировать страницу, ссылки практически не видно.

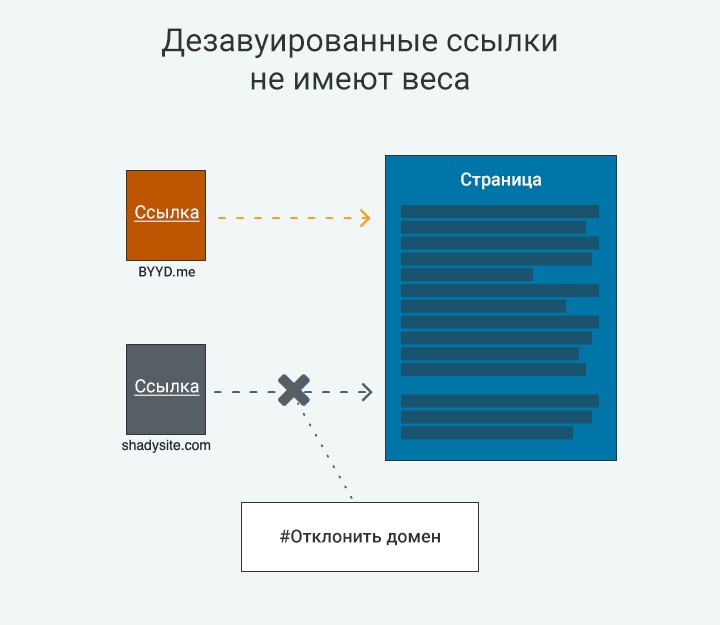

19. Дезавуированные ссылки не имеют веса

Если вы создали несколько теневых ссылок или были поражены штрафом, вы можете использовать инструмент Google Disavow, чтобы помочь стереть ваши погрешности.

Google эффективно удаляет эти обратные ссылки для рассмотрения во время сканирования.

С другой стороны, если Google думает, что вы ошиблись с вашим файлом Disavow, он может полностью игнорировать его — вероятно, чтобы предотвратить нанесение вреда.

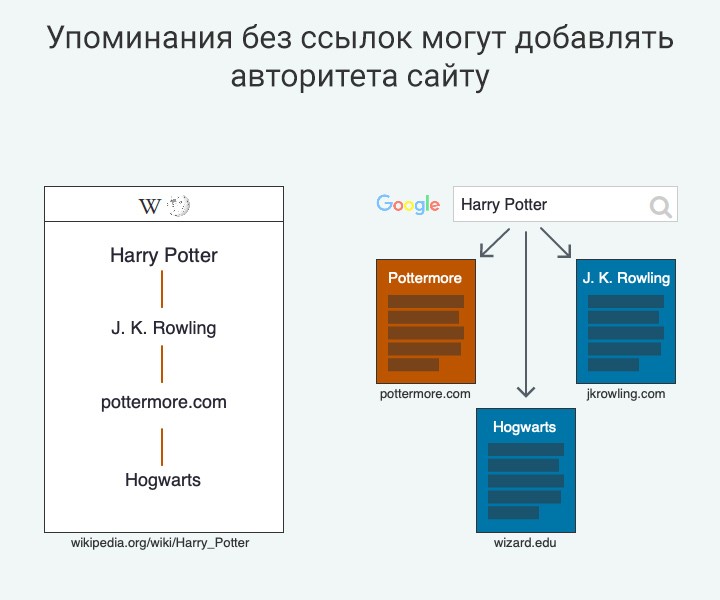

20. Упоминания без ссылок могут добавлять авторитета сайту

Google распознает темы (таких как бизнес, человек, произведение искусства и т. д.) без наличия HTML-ссылок.

Таким образом, упоминания без ссылки могут по-прежнему добавлять авторитета сайту.

Источник: moz.com